Hand-Object Interaction Image Generation (NeurIPS2022)

Hand-Object Interaction Image Generation

https://play-with-hoi-generation.github.io/

かなり長い間放置してしまっていたけれど、少しずつ再開していこうと思う。

とりあえず、再開の第1弾はNeurIPS2022で発表されたHand-Object Interaction Image Generationを紹介しようと思う。

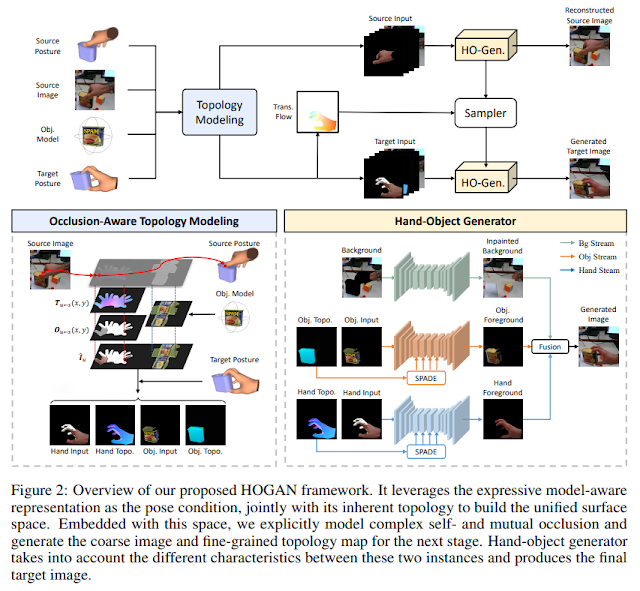

こちらの論文は上の図にあるように、物体を把持している画像を入力とし、Targetとなる手と物体の姿勢にあった画像を出力する手法となっている。指定した手の姿勢にあった手画像を生成する手法はこれまでに提案されていたが、このように物体と手のインタラクションを考慮した把持画像生成については、こちらの論文が初めての取り組みとなっている。

この手法では、入力画像に対する三次元の手姿勢および物体姿勢は何らかの手法によって推定されていることを前提としている。手のモデルと物体のモデルにはUVテクスチャ座標が定義されており、推定されている手姿勢と物体姿勢から部分的なテクスチャ情報を入力画像から取得することが可能となっている。この情報を用いることで、Targetの手姿勢、物体姿勢に対応する画像をレンダリングすることが可能となる。しかし、この段階では、遮蔽の問題があるため、欠損のある画像がレンダリングされる。

そこで、次の段階として、SPADEを用いて、欠損のない物体画像、欠損のない手画像を生成する。また、背景については、Image Inpainting手法を用いて補間を行う。最終的に、これら3枚の画像を合成することで、Target姿勢に対応した把持画像を生成することが可能となる。

生成結果は上のようになっており、手画像を生成する既存手法を単純に物体も考慮できるように拡張した方法に比べて、高品位な把持画像を生成することができている。

現状は、入力画像に対応する三次元の物体姿勢、手姿勢の推定が高精度に行われていないといけない、画像中の物体の3次元モデルが必要、などの多くの制約が存在する。

コメント

コメントを投稿